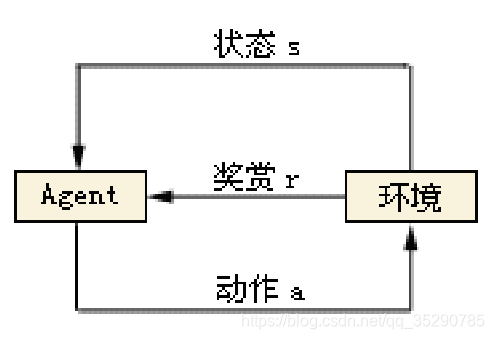

强化学习没有任何的标签来告诉算法应该怎么做,它会先去尝试做一些动作,然后得到一个结果,通过判断这个结果是对还是错来对之前的动作进行反馈(对了会获得奖赏,得分,通过最后所有最高得分确定,奖赏相当于标签)。

强化学习中Agent的组成:

一个Agent由Policy(策略)、Value function(价值函数)、Model(模型)三部分组成,但这三部分不是必

须同时存在的。

Policy(策略):它会观察当前环境得到state(状态),根据state(状态)来决定action(动作),它有两种

形式。一种是Deterministic policy(确定策略),即在某种环境下就执行某种动作。另一种是Stochatic

policy(随机策略),即它是在某种环境下以一定的概率执行某个动作。

Value function(价值函数):它会观察当前环境的state(状态),预测当前state(状态)下获得reward(奖赏)的期望,用于衡量当前状态的好坏。

Model(模型):它会预测环境下一步会做出什么样的改变,从而预测Agent接受到的state(状态)或者reward(奖赏)是什么。因而有两种model(模型),一种是预测下一个state(状态)的transition model。

一种是预测下一次reward(奖赏)的reward model。

在学习的过程中,会有一个Exploration(探索)和Exploitaion(利用)之间的平衡。

Exploration(探索):会放弃一些已知的reward信息,而去尝试一些新的选择。

Exploitation(利用):根据已知的信息最大化reward(奖赏)。

1